리벨리온(Rebellions)과 레드햇(Rad Hat)이 주최하고 파이토치 코리아와 스퀴즈비츠(SqueezeBits)가 함께 기획한 제1회 vLLM 커뮤니티 밋업 코리아 행사가 2025년 8월 19일 서울에서 열렸습니다. 이번 행사는 350명 이상이 등록했고, 참가자 80% 이상이 업계 전문가였습니다. 이 가운데 약 80%가 소프트웨어 엔지니어와 연구원으로, 실무진의 큰 관심이 두드러졌습니다.

이는 프로덕션 환경에 AI를 본격적으로 적용하는 곳이 늘면서 추론(Inference) 워크로드 처리의 사실상 표준 모델 서빙 플랫폼으로 자리잡은 vLLM이 AI 기술 생태계 전반에서 빠르게 채택되고 있는 흐름과 맞닿아 있습니다. 참고로 글로벌 클라우드 사업자부터 MLOps/LLMOps 플랫폼 기업과 레드햇, IBM, 스노우플레이크 등 엔터프라이즈 솔루션 기업까지 vLLM을 자사 서비스와 제품에 통합하고 있습니다.

사실상의 표준 모델 서빙 플랫폼

첫 번째 세션은 레드햇 시니어 머신 러닝 엔지니어인 니콜로 루케시(Nicolo Lucchesi)가 “vLLM은 가장 빠르고 사용하기 쉬운 오픈 소스 LLM 추론 및 서빙 엔진을 지향한다”는 프로젝트 소개로 발표를 시작했습니다. 그는 LLM 추론 시 가장 큰 성능 병목 요소인 KV 캐시 메모리 관리 문제를 해결하는 PagedAttention 기술을 이해하기 쉽게 소개했습니다. 이 기술은 필요할 때만 물리 메모리에 할당하여 메모리 낭비를 최대 90%까지 줄일 수 있습니다.

vLLM의 또 다른 핵심으로 스케줄링 기술인 연속 배치(Continuous Batching)를 꼽을 수 있습니다. 이 기법을 적용하면 AI 가속기를 유휴 시간 없이 항상 최대 성능으로 사용할 수 있습니다. 한편, 니콜로 루케시는 TPU 관련해 현재 진행 중인 작업을 공유하며 특정 하드웨어 종속 없이 고성능 추론 서비스를 제공할 수 있다는 사실도 알렸습니다.

첫 번째 세션이 참관객들에게 전한 메시지는 분명했습니다. 이제 AI 개발자들은 복잡한 메모리 관리나 하드웨어 최적화를 고민할 필요 없이 vLLM으로 간편하게 고성능, 고효율 LLM 서빙 환경을 구축할 수 있게 되었다는 것입니다.

두 번째 세션은 레드햇 AI 추론 서버 엔지니어인 다니엘레 트리피로(Daniele Trifirò)가 vLLM 오픈 소스 커뮤니티에 대한 소개와 함께 프로젝트 기여 방법을 안내했습니다. 그가 강조한 것은 vLLM 프로젝트의 역동성입니다. 등장한 지 몇 년 되지 않은 프로젝트가 AI 기술 스택에서 핵심 위치에 자리를 잡고 커뮤니티와 IT 업계의 전폭적인 지원을 받는 것은 흔히 볼 수 있는 일이 아닙니다. 다니엘레 트리피로는 “vLLM은 3주마다 새 버전이 나오고 릴리스마다 수만 라인의 코드가 바뀌는 매우 큰 프로젝트”라고 설명했습니다.

AI 가속기 선택지 확장

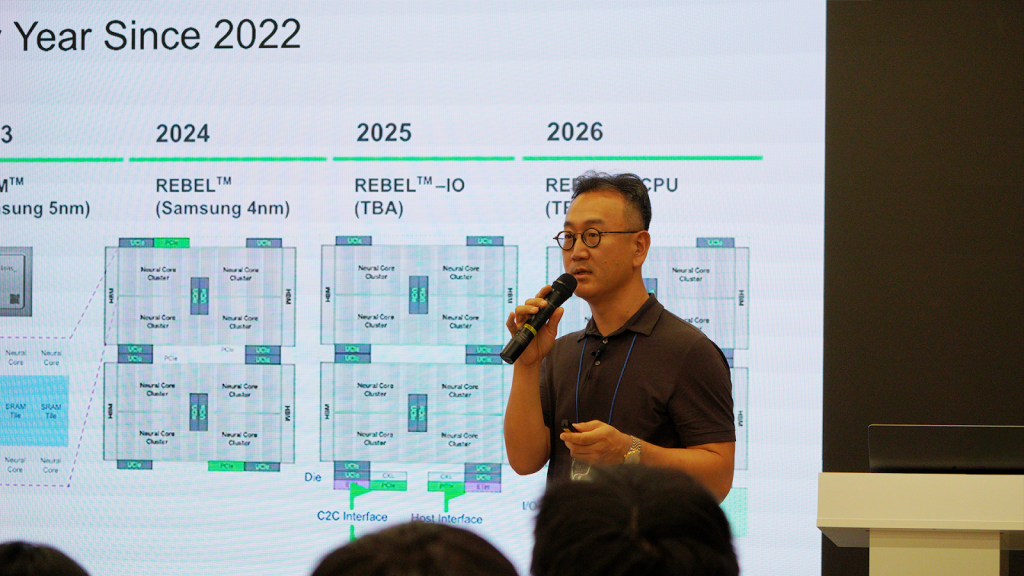

세 번째 세션은 리벨리온의 소프트웨어 아키텍트 총괄인 김홍석 박사가 vLLM이 어떻게 AI 가속기 시장의 판도를 바꿀지 그리고 리벨리온의 NPU ATOM™을 vLLM 생태계에 통합한 것이 어떤 의미를 갖는지 설명했습니다.

김 박사는 vLLM의 추구하는 표준화된 접근 방식이 AI 가속기 시장의 판도를 바꿀 것이라고 말했습니다. “vLLM에 익숙한 사용자라면 리벨리온의 NPU와 NVIDIA의 GPU를 사용할 때 큰 차이를 느끼지 못할 겁니다. 이런 체감 효과가 누적되면 몇 년 후에는 시장 판도가 많이 달라질 것으로 조심스럽게 예상합니다.”라고 의견을 밝혔습니다.

추론 워크로드는 NPU가 성능, 전력, 비용 등 여러 면에서 유리합니다. 하지만 로우 레벨에서 해야 하는 최적화 작업에 대한 막연한 부담이 있었습니다. vLLM을 활용하면 로우 레벨 엔지니어링이 아니라 서비스에 집중할 수 있습니다. 관련해 김 박사는 vLLM의 최적화 기술을 활용하면 복잡하게 사전 작업을 하지 않아도 리벨리온의 NPU에서 MoE(Mixture of Expert) 모델을 최고의 성능으로 서빙할 수 있다고 설명했습니다.

vLLM을 더욱 강력하게 만드는 양자화

마지막 세션으로 김형준 스퀴즈비츠 대표는 LLM 추론의 필수 최적화 기법으로 자리 잡은 ‘양자화(Quantization)’를 주제로 발표했습니다. 양자화는 vLLM의 핵심 기술인 PagedAttention과 결합될 때 더 높은 처리량, 더 빠른 응답 속도 등의 시너지 효과를 냅니다. 김 대표는 vLLM에서 양자화를 사용하는 두 가지 방법을 소개했습니다. 첫째는 허깅페이스 같은 모델 리포지토리에 이미 양자화되어 올라온 모델을 사용하는 것이고 둘째는 직접 양자화를 수행하는 것입니다. 그는 하드웨어에 최적화된 성능을 내려면 직접 양자화를 해야 한다며 오픈 소스 라이브러리 ‘llm-compressor’를 소개했습니다. 이를 이용하는 과정은 복잡하지만 AI 가속기의 성능과 효율을 극대화할 수 있습니다. 또한 스퀴즈비츠가 개발한 오픈소스 툴킷인 Fits on Chips를 소개했는데, 이는 사용자가 양자화된 모델의 품질을 평가할 수 있게 해주며, 모델 최적화와 추론 가속화를 모두 지원합니다.

향후 계획

이번 밋업을 시작으로 한국에서도 정기적으로 vLLM 관련 모임이 이어질 예정입니다. 리벨리온은 스퀴즈비츠, 파이토치 코리아, 파이썬 코리아와 함께 계속 커뮤니티 활성화를 적극 지원할 계획입니다. 앞으로 vLLM을 주제로 한 핸즈온 워크숍, 개발자 밋업, 소그룹 세션 등을 함께 준비하면서, 더 많은 분들이 참여하고 교류할 수 있는 장을 만들어가겠습니다.

vLLM Blog 보러가기 →

Share This: