Enterprise Al Solution

Full PackagedエンタープライズAIのサービスソリューション

エンタープライズAIサービング向けのFull Lifecycle対応ソリューション

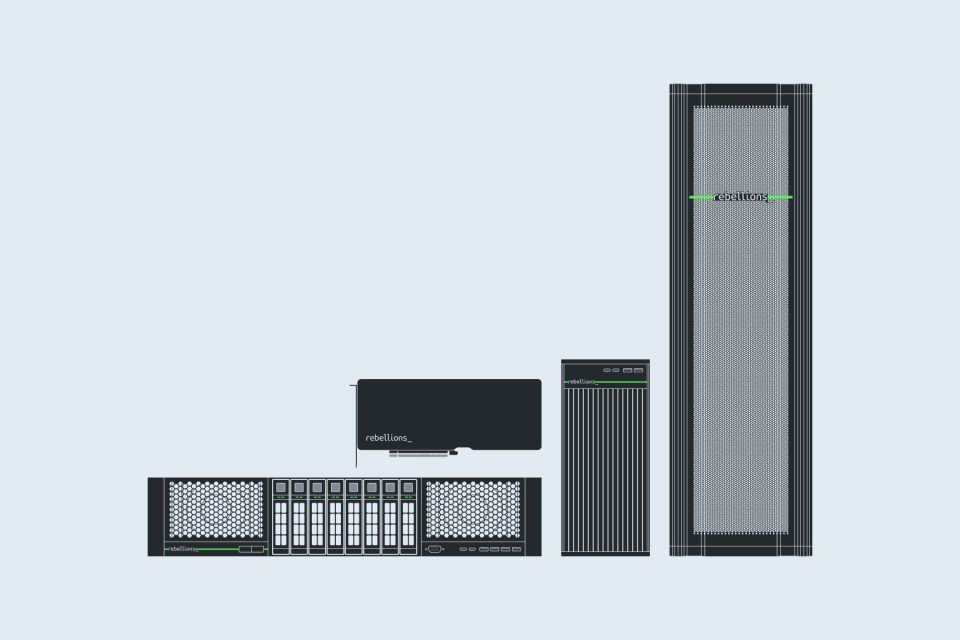

Rebellions Enterprise AI Solutionは、ATOM™-Max PodでエンタープライズAIサービスのFull Lifecycleを高いリソース効率でサポートするSWです。さまざまなAIサービスや大量のリクエスト、大型モデルに最適化したノード単位の分散処理向け開発ツールキットを提供します。企業のインフラチームには自動化したAIインフラの運用ツールを、開発チームには環境設定やソフトウェア構成を悩まずにすぐ使える独立した開発環境を提供します。

Full Lifecycle Support from Dev to Deploy

テスト用Podを簡単に生成でき、VS CodeやJupyterなどのIDEツールで開発、テスト、デバッグ、デプロイおよびアップデート作業ができます。初期設定やソフトウェア構成を悩まなくて済むように、E2E全体の開発サイクルをサポートします。

Automated Resource Orchestration

管理者は開発チームのためのAIリソースを簡単に生成でき、ユーザー認証および権限管理、モニタリング機能を用いて運用できます。自動化されたAIインフラの運用ツールを導入し、管理の利便性および効率性を最大化できます。

Prebuilt Multi-Tenant Development & Serving System

企業は多数のAIサービスの開発やテスト、デプロイ、運用を同時に行わなければなりません。複数の開発者とチームがお互いの作業に干渉せずに、同時に進められるよう、独立したリソース管理および実行環境を提供します。

Ready-to-Use SW for Cost-Efficient Distributed Serving

AIサービスのリクエスト構造に最適化したノード間の分散処理環境は、最小限のリソースで大量のリクエストを処理できます。分散処理向けに構成されているソフトウェアスタックで、容易に最適化できます。

Development Toolkit for Resource-Intensive Model

サーバー間の通信が欠かせないリソース集約型の大規模AIモデル(Reasoning AIなど)の推論にも対応します。RDMA基盤の高速ネットワーク環境および活用ガイドを通じて低遅延で高性能なAIサービスを実現できます。

Core Technology & Components

Developer-Friendly Environment

使いやすいIDEやKubernetes、Rayといった分散処理ソフトウェアスタックを提供し、開発しやすい環境を実現します。

vLLM Devpack

vLLM Devpackは、vLLMのエンジンやさまざまなツール、PyTorch、Triton、Rebellions SDKを統合コンテナイメージで提供します。

AI Orchestration

大量のリクエストに対してもRay、K8s、vLLMでサーバーを分散・共有・スケジューリングし、ワークロードを効率よく処理します。